TI/LLM: Różnice pomiędzy wersjami

Z Brain-wiki

(→Dane) |

|||

| Linia 2: | Linia 2: | ||

Na wykładzie o [[TI/Sztuczne_sieci_neuronowe|sztucznych sieciach neuronowych]] zapoznaliśmy się z procesem uczenia sieci. Uczenie i używanie dużych modeli językowych opiera się na tych samych podstawach, wprowadzając jednocześnie wiele nowości. | Na wykładzie o [[TI/Sztuczne_sieci_neuronowe|sztucznych sieciach neuronowych]] zapoznaliśmy się z procesem uczenia sieci. Uczenie i używanie dużych modeli językowych opiera się na tych samych podstawach, wprowadzając jednocześnie wiele nowości. | ||

| − | + | ==Dane== | |

| − | |||

| − | |||

[[Plik:Fineweb.png|noborder|800px]] | [[Plik:Fineweb.png|noborder|800px]] | ||

| Linia 10: | Linia 8: | ||

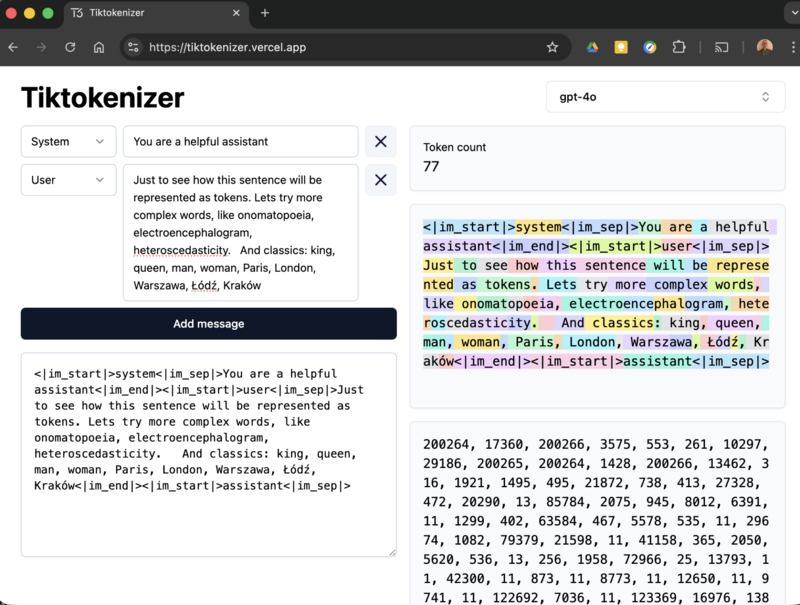

| − | + | ==Tokenizacja== | |

[[Plik:Tiktokenizer.png|noborder|800px]] | [[Plik:Tiktokenizer.png|noborder|800px]] | ||

https://tiktokenizer.vercel.app/ | https://tiktokenizer.vercel.app/ | ||

Wersja z 11:08, 27 paź 2025

Duże modele językowe — Large language models, LLM

Na wykładzie o sztucznych sieciach neuronowych zapoznaliśmy się z procesem uczenia sieci. Uczenie i używanie dużych modeli językowych opiera się na tych samych podstawach, wprowadzając jednocześnie wiele nowości.

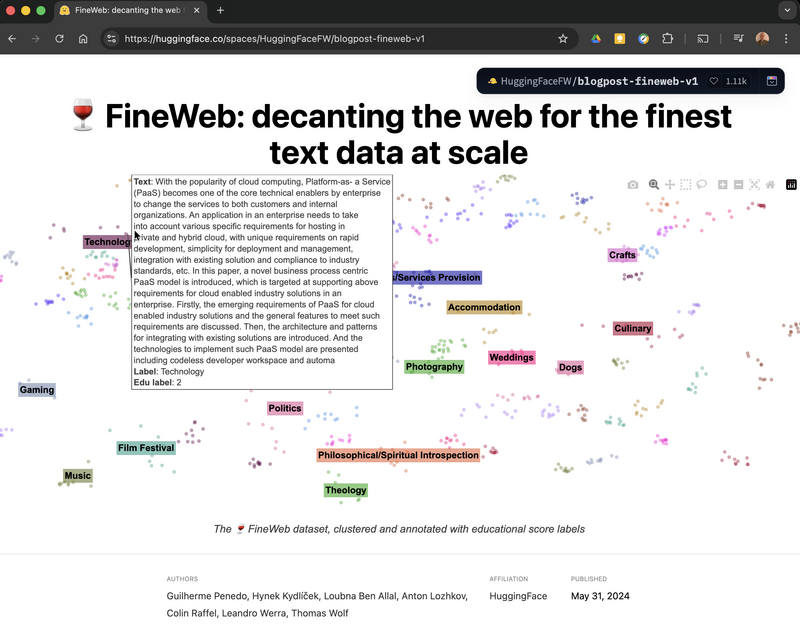

Dane

https://huggingface.co/spaces/HuggingFaceFW/blogpost-fineweb-v1