TI/Media społecznościowe: Różnice pomiędzy wersjami

| (Nie pokazano 33 pośrednich wersji utworzonych przez tego samego użytkownika) | |||

| Linia 1: | Linia 1: | ||

| − | + | =[[Technologie informacyjne i komunikacyjne|⬆]] Rząd dusz oddajemy algorytmom= | |

| + | |||

| + | ==WWW vs. media społecznościowe== | ||

WWW powstał w latach 90. ubiegłego wieku jako medium z założenia dwukierunkowe: pierwsze przeglądarki miały wbudowane edytory HTML, aby każdy użytkownik mógł zarówno przeglądać jak i tworzyć treści. Pomimo tego, Internet upodobnił się dość szybko do innych mediów, w których treści tworzone są przez profesjonalne, komercyjne zepoły, a większość użytkowników tylko je ogląda — niezależnie od faktu, że do dzisiaj każdy ma możliwość stworzenia własnej strony WWW i samodzielnego udostępniania własnych treści (w granicach prawa). | WWW powstał w latach 90. ubiegłego wieku jako medium z założenia dwukierunkowe: pierwsze przeglądarki miały wbudowane edytory HTML, aby każdy użytkownik mógł zarówno przeglądać jak i tworzyć treści. Pomimo tego, Internet upodobnił się dość szybko do innych mediów, w których treści tworzone są przez profesjonalne, komercyjne zepoły, a większość użytkowników tylko je ogląda — niezależnie od faktu, że do dzisiaj każdy ma możliwość stworzenia własnej strony WWW i samodzielnego udostępniania własnych treści (w granicach prawa). | ||

| − | Zmianę tego modelu przyniosły dopiero na początku wieku idee Web 2.0, których | + | Zmianę tego modelu przyniosły dopiero na początku wieku idee Web 2.0, których najpopularniejszą implementacją stały się media społecznościowe. Choć formalnie można odróżniać media od serwisów czy platform społecznościowych, klasyfikować osobno serwisy nakierowane na udostępnianie filmów, zdjęć czy ogólnie tworzenie sieci społecznych itp., tu również możemy podejść do definicji zgodnie ze staropolskim [https://pl.wikiquote.org/wiki/Ko%C5%84_jaki_jest,_ka%C5%BCdy_widzi "Koń jaki jest, każdy widzi"] — wiadomo, że chodzi o Facebooka, Instagrama, Twittera (aktualnie X), YouTube, TikToka, WeChat (w Chinach) itp. |

| − | Do mediów społecznościowych zaliczane są też komunikatory takie jak WhatsApp czy Telegram, umożliwiające | + | Do mediów społecznościowych zaliczane są też komunikatory takie jak WhatsApp czy Telegram, umożliwiające publikowanie treści potencjalnie dostępnych dla każdego użytkownika danego serwisu. |

[[Plik:Snowcrash.jpg|bezramki|150px|right]] | [[Plik:Snowcrash.jpg|bezramki|150px|right]] | ||

| Linia 11: | Linia 13: | ||

| − | =Rząd dusz<ref><blockquote> | + | =Rząd dusz<ref>Adam Mickiewicz, ''Dziady'', część III "Wielka Improwizacja": |

| − | Daj mi rząd dusz! - Tak gardzę tą martwą budową,<br/> | + | <blockquote> |

| + | (...) Daj mi rząd dusz! - Tak gardzę tą martwą budową,<br/> | ||

Którą gmin światem zowie i przywykł ją chwalić,<br/> | Którą gmin światem zowie i przywykł ją chwalić,<br/> | ||

Żem nie próbował dotąd, czyli moje słowo<br/> | Żem nie próbował dotąd, czyli moje słowo<br/> | ||

| − | Nie mogłoby jej wnet zwalić. | + | Nie mogłoby jej wnet zwalić. (...) |

| − | </blockquote> | + | </blockquote></ref> oddajemy algorytmom= |

| + | |||

| + | W ostatnim dwudziestoleciu ten niebezpieczny proces przebiega w trzech głównych etapach: | ||

| − | |||

==1. Maksymalizacja zaangażowania użytkowników== | ==1. Maksymalizacja zaangażowania użytkowników== | ||

| − | Głównym miernikiem wartości konkurujących platform jest liczba aktywnych użytkowników i czas przez nich spędzany na przeglądaniu treści podsuwanych przez serwis | + | Głównym miernikiem wartości konkurujących platform jest liczba aktywnych użytkowników i czas przez nich spędzany na przeglądaniu treści podsuwanych przez serwis. W tym kontekście naturalnym i oczywistym wydaje się fakt, że serwisy podsuwają użytkownikom takie treści, na które użytkownicy najczęściej "klikają". Cel wydaje się oczywisty i znany — dokładnie tak samo od dziesięcioleci stacje telewizyjne maksymalizują "oglądalność", bo jeśli stację ogląda więcej widzów, to emitowane w niej reklamy dotrą do większej liczby odbiorców, więc czas reklamowy jest więcej wart, co podnosi zyski itd. |

Treści propagowane w mediach społecznościowych wybierają pod kątem maksymalizacji zaangażowania algorytmy, opartę o statystykę i [[TI/Uczenie_maszynowe|uczenie maszynowe]]. Problem leży w tym, że dużo większe zaangażowanie użytkowników gwarantują treści brutalne, antagonizujące i często poniżające — oczywiście "tych innych", a nie oglądających je użytkowników. I nie ma tu wielkiego znaczenia, czy są to treści prawdziwe, zmyślone z głupoty czy fałszowane dla osiągnięcia konkretnych celów. Prawda jest zwykle znacznie mniej ciekawa i sensacyjna, dlatego treści propagujące wspópracę i empatię są statystycznie znacznie mniej angażujące. Prowadzi to do propagowania, popularyzowania i przez to wzmacniania treści bardzo często szkodliwych i fałszywych. Antagonizowanie przeciwko sobie grup społecznych, etniczych i narodów nie jest w tym przypadku częścią "tajnego planu" — u podstaw leży maksymalizowanie zysku firm prowadzących serwisy, które wciąż nie są pociągane do odpowiedzialności za konsekwencje wyrządzanego zła — skuteczną obroną jest tu powoływanie się na wolność słowa i zrzucanie odpowiedzialności na użytkowników publikujących takie treści. To tak, jakby gazeta lub stacja telewizyjna publikowała codziennie na pierwszych stronach i w czasie największej oglądalności wywiady z osobami gloryfikującymi przemoc i faszyzm. W tradycyjnych mediach za wyświetlane treści odpowiadają firmy — stacje telewizyjne, radiowe, redakcje gazet. Ich wpływ na opinie społeczeństwa jest ogromny, co wiemy od dziesięcioleci, stąd np. pojęcie [https://pl.wikipedia.org/wiki/Etyka_dziennikarska etyki dziennikarskiej]. Jak widać problem nie jest nowy, jednak rozwiązania są wdrażane powoli i z mocnym oporem firm, czerpiących z tych serwisów gigantyczne zyski. | Treści propagowane w mediach społecznościowych wybierają pod kątem maksymalizacji zaangażowania algorytmy, opartę o statystykę i [[TI/Uczenie_maszynowe|uczenie maszynowe]]. Problem leży w tym, że dużo większe zaangażowanie użytkowników gwarantują treści brutalne, antagonizujące i często poniżające — oczywiście "tych innych", a nie oglądających je użytkowników. I nie ma tu wielkiego znaczenia, czy są to treści prawdziwe, zmyślone z głupoty czy fałszowane dla osiągnięcia konkretnych celów. Prawda jest zwykle znacznie mniej ciekawa i sensacyjna, dlatego treści propagujące wspópracę i empatię są statystycznie znacznie mniej angażujące. Prowadzi to do propagowania, popularyzowania i przez to wzmacniania treści bardzo często szkodliwych i fałszywych. Antagonizowanie przeciwko sobie grup społecznych, etniczych i narodów nie jest w tym przypadku częścią "tajnego planu" — u podstaw leży maksymalizowanie zysku firm prowadzących serwisy, które wciąż nie są pociągane do odpowiedzialności za konsekwencje wyrządzanego zła — skuteczną obroną jest tu powoływanie się na wolność słowa i zrzucanie odpowiedzialności na użytkowników publikujących takie treści. To tak, jakby gazeta lub stacja telewizyjna publikowała codziennie na pierwszych stronach i w czasie największej oglądalności wywiady z osobami gloryfikującymi przemoc i faszyzm. W tradycyjnych mediach za wyświetlane treści odpowiadają firmy — stacje telewizyjne, radiowe, redakcje gazet. Ich wpływ na opinie społeczeństwa jest ogromny, co wiemy od dziesięcioleci, stąd np. pojęcie [https://pl.wikipedia.org/wiki/Etyka_dziennikarska etyki dziennikarskiej]. Jak widać problem nie jest nowy, jednak rozwiązania są wdrażane powoli i z mocnym oporem firm, czerpiących z tych serwisów gigantyczne zyski. | ||

| − | Propagowanie, czyli podpowiadanie/podsuwanie treści najmocniej oddziałujących na niskie uczucia (obrazy przemocy, teorie spiskowe) mogą prowadzić do tragedii takich | + | [[Plik:Wirathu TIME.png|noborder|right|170px]] |

| − | + | Propagowanie, czyli podpowiadanie/podsuwanie treści najmocniej oddziałujących na niskie uczucia (obrazy przemocy, teorie spiskowe) mogą prowadzić do tragedii takich jak ludobójstwo i czystki etniczne w Myanmar (dawniej Birma) w latach 2016--2017, wynikłe w dużej części z [https://en.wikipedia.org/wiki/Rohingya_genocide#Facebook_content_management_controversy rozpropagowania za pośrednictwem platformy facebook] mowy nienawiści buddyjskiego mnicha Ashina Wirathu, którego posty szkalujące Rohingya były powielane bez porównania mocniej niż opinie innych mnichów, wzywających do współczucia. | |

| + | ===Bańki informacyjne=== | ||

| + | Efektem, który niejako "przy okazji" powodują algorytmy rekomendujące treści, jest [https://pl.wikipedia.org/wiki/Efekt_potwierdzenia efekt potwierdzenia] (ang. ''confirmation bias''): w serwisie widzimy tylko treści odpowiadające naszym przekonanion i przesądom, i stajemy się odizolowani od argumentów przeciwnych, por. [https://youtu.be/uaaC57tcci0 trailer filmu "The Social Dilemma"]. Algorytmy realizujące te założenia od dziesięcioleci okazały się na tyle efektywne, że na długo przed SI doprowadziły do polaryzacji społeczeństw przez tworzenie tzw. [https://pl.wikipedia.org/wiki/Bańka_filtrująca baniek informacyjnych]. | ||

| − | ==2. Algorytmy poznają nasze | + | ==2. Algorytmy poznają nasze słabości== |

| − | Mikrotargetowanie (ang. [https://en.wikipedia.org/wiki/Microtargeting microtargeting]) to kolejny — z pozoru niewinny — mechanizm, zwiększający efektywność reklam. | + | Mikrotargetowanie (ang. [https://en.wikipedia.org/wiki/Microtargeting microtargeting]) to kolejny — z pozoru niewinny — mechanizm, zwiększający efektywność reklam. Oczywistym wydaje się, że nie ma sensu wyświetlanie reklam nowych modeli samochodów osobom, które nie mają prawa jazdy, lub w ogóle nie interesują się samochodami. Skąd algorytmy wiedzą, co interesuje konkretne osoby? Pokazał to [https://pl.wikipedia.org/wiki/Micha%C5%82_Kosi%C5%84ski Michał Kosiński]: |

<blockquote> | <blockquote> | ||

| − | (...) Według jego badań algorytm ten jest w stanie określić preferencje seksualne (u mężczyzn skutecznie w 88% przypadków), wygląd, zainteresowania, poziom inteligencji, pochodzenie etniczne i kolor skóry (u Amerykanów skutecznie w 95% przypadków), wyznanie, poziom zadowolenia z życia, uzależnienia, wiek, płeć oraz poglądy społeczne, religijne i polityczne ( | + | (...) Według jego badań algorytm ten jest w stanie określić preferencje seksualne (u mężczyzn skutecznie w 88% przypadków), wygląd, zainteresowania, poziom inteligencji, pochodzenie etniczne i kolor skóry (u Amerykanów skutecznie w 95% przypadków), wyznanie, poziom zadowolenia z życia, uzależnienia, wiek, płeć oraz poglądy społeczne, religijne i polityczne (...) na podstawie 68 polubień na Facebooku.<ref>https://pl.wikipedia.org/wiki/Michał_Kosiński</ref> |

</blockquote> | </blockquote> | ||

| − | Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. | + | Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. [https://en.wikipedia.org/wiki/Facebook–Cambridge_Analytica_data_scandal historia Cambridge Analitica] i film "The Great Hack" ([https://youtu.be/iX8GxLP1FHo trailer]). |

| + | |||

| + | |||

| + | ==3. SI upraszcza fałszerstwa na wielką skalę== | ||

| + | W ostatnich dzisięcioleciach cyberwojna w przestrzeni mediów społecznościowych prowadzona była przez duże i finansowane przez rządy przedsiębiorstwa, jak np. [https://pl.wikipedia.org/wiki/Agencja_Badań_Internetowych farma trolli] założona przez [https://pl.wikipedia.org/wiki/Jewgienij_Prigożyn Prigożyna] w Petersburgu. Setki pracowników pisały setki blogów i komentarzy nakierowanych na | ||

| + | ''powielanie rosyjskiej narracji, rozprzestrzenianie fałszywych informacji, wywoływanie skrajnych postaw społecznych i politycznych oraz dezinformowanie zagranicznej opinii publicznej (...)''<ref>https://pl.wikipedia.org/wiki/Agencja_Badań_Internetowych</ref>. | ||

| + | Tych urzędników może zastąpić [[TI/Sztuczna_Inteligencja|sztuczna inteligencja]]. Zamiast siermiężnych tekstów, pełnych błędów językowych i łatwych do rozpoznania, pozwala tanio i masowo produkować błyskotliwe, inteligentne i pisane doskonałym językiem kłamstwa na dowolnie wybrany temat, poparte tyleż przekonywującymi co fałszywymi zdjęciami i filmami. Jeśli dodamy do tego wspomniany powyżej mikrotargeting, nieodróżnialne i liczniejsze od ludzi boty o "bardzo podobnych do naszych przekonaniach i obawach" opanują cybeprzestrzeń i będą w stanie przekonać nas do dowolnie wybranej przez mocodawców bzdury — albo też ostatecznie podważą zaufanie do komunikacji elektronicznej. | ||

| − | |||

| − | |||

| + | <hr/> | ||

| + | <references/> | ||

<div align="right"> | <div align="right"> | ||

[[TI/Bazy danych|⬅]] [[Technologie informacyjne i komunikacyjne|⬆]] [[TI/Kryptografia|⮕]] | [[TI/Bazy danych|⬅]] [[Technologie informacyjne i komunikacyjne|⬆]] [[TI/Kryptografia|⮕]] | ||

Aktualna wersja na dzień 17:41, 26 kwi 2025

Spis treści

⬆ Rząd dusz oddajemy algorytmom

WWW vs. media społecznościowe

WWW powstał w latach 90. ubiegłego wieku jako medium z założenia dwukierunkowe: pierwsze przeglądarki miały wbudowane edytory HTML, aby każdy użytkownik mógł zarówno przeglądać jak i tworzyć treści. Pomimo tego, Internet upodobnił się dość szybko do innych mediów, w których treści tworzone są przez profesjonalne, komercyjne zepoły, a większość użytkowników tylko je ogląda — niezależnie od faktu, że do dzisiaj każdy ma możliwość stworzenia własnej strony WWW i samodzielnego udostępniania własnych treści (w granicach prawa).

Zmianę tego modelu przyniosły dopiero na początku wieku idee Web 2.0, których najpopularniejszą implementacją stały się media społecznościowe. Choć formalnie można odróżniać media od serwisów czy platform społecznościowych, klasyfikować osobno serwisy nakierowane na udostępnianie filmów, zdjęć czy ogólnie tworzenie sieci społecznych itp., tu również możemy podejść do definicji zgodnie ze staropolskim "Koń jaki jest, każdy widzi" — wiadomo, że chodzi o Facebooka, Instagrama, Twittera (aktualnie X), YouTube, TikToka, WeChat (w Chinach) itp. Do mediów społecznościowych zaliczane są też komunikatory takie jak WhatsApp czy Telegram, umożliwiające publikowanie treści potencjalnie dostępnych dla każdego użytkownika danego serwisu.

Media społecznościowe oferują dużo łatwiejszy sposób publikowania, oznaczania, oraz funkcje mierzące popularność treści. Ceną za te udogodnienia jest, że wszystkie te treści znajdować się muszą na sewerach firmy udostępniającej dany serwis, oraz — mniej lub bardziej, zależnie od regulaminów — stają się własnością firm te serwisy prowadzących. To najważniejsza różnica w porównaniu do publikowania treści na własnych stronach WWW.

W roku 2021 firma Facebook nabyła, wraz z prawami do headsetu Oculus, firmę Oculus VR, stworzoną przez Palmera Luckey (który następnie w 2017 założył firmę Anduril), a w 2021 wręcz zmieniła nazwę na "Meta", aby podkreślić zaangażowanie w urzeczywistnienie wizji Metaverse, przedstawionej w 1992 roku w książce Neala Stephensona Snow Crash.

Rząd dusz[1] oddajemy algorytmom

W ostatnim dwudziestoleciu ten niebezpieczny proces przebiega w trzech głównych etapach:

1. Maksymalizacja zaangażowania użytkowników

Głównym miernikiem wartości konkurujących platform jest liczba aktywnych użytkowników i czas przez nich spędzany na przeglądaniu treści podsuwanych przez serwis. W tym kontekście naturalnym i oczywistym wydaje się fakt, że serwisy podsuwają użytkownikom takie treści, na które użytkownicy najczęściej "klikają". Cel wydaje się oczywisty i znany — dokładnie tak samo od dziesięcioleci stacje telewizyjne maksymalizują "oglądalność", bo jeśli stację ogląda więcej widzów, to emitowane w niej reklamy dotrą do większej liczby odbiorców, więc czas reklamowy jest więcej wart, co podnosi zyski itd.

Treści propagowane w mediach społecznościowych wybierają pod kątem maksymalizacji zaangażowania algorytmy, opartę o statystykę i uczenie maszynowe. Problem leży w tym, że dużo większe zaangażowanie użytkowników gwarantują treści brutalne, antagonizujące i często poniżające — oczywiście "tych innych", a nie oglądających je użytkowników. I nie ma tu wielkiego znaczenia, czy są to treści prawdziwe, zmyślone z głupoty czy fałszowane dla osiągnięcia konkretnych celów. Prawda jest zwykle znacznie mniej ciekawa i sensacyjna, dlatego treści propagujące wspópracę i empatię są statystycznie znacznie mniej angażujące. Prowadzi to do propagowania, popularyzowania i przez to wzmacniania treści bardzo często szkodliwych i fałszywych. Antagonizowanie przeciwko sobie grup społecznych, etniczych i narodów nie jest w tym przypadku częścią "tajnego planu" — u podstaw leży maksymalizowanie zysku firm prowadzących serwisy, które wciąż nie są pociągane do odpowiedzialności za konsekwencje wyrządzanego zła — skuteczną obroną jest tu powoływanie się na wolność słowa i zrzucanie odpowiedzialności na użytkowników publikujących takie treści. To tak, jakby gazeta lub stacja telewizyjna publikowała codziennie na pierwszych stronach i w czasie największej oglądalności wywiady z osobami gloryfikującymi przemoc i faszyzm. W tradycyjnych mediach za wyświetlane treści odpowiadają firmy — stacje telewizyjne, radiowe, redakcje gazet. Ich wpływ na opinie społeczeństwa jest ogromny, co wiemy od dziesięcioleci, stąd np. pojęcie etyki dziennikarskiej. Jak widać problem nie jest nowy, jednak rozwiązania są wdrażane powoli i z mocnym oporem firm, czerpiących z tych serwisów gigantyczne zyski.

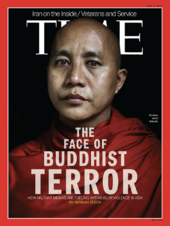

Propagowanie, czyli podpowiadanie/podsuwanie treści najmocniej oddziałujących na niskie uczucia (obrazy przemocy, teorie spiskowe) mogą prowadzić do tragedii takich jak ludobójstwo i czystki etniczne w Myanmar (dawniej Birma) w latach 2016--2017, wynikłe w dużej części z rozpropagowania za pośrednictwem platformy facebook mowy nienawiści buddyjskiego mnicha Ashina Wirathu, którego posty szkalujące Rohingya były powielane bez porównania mocniej niż opinie innych mnichów, wzywających do współczucia.

Bańki informacyjne

Efektem, który niejako "przy okazji" powodują algorytmy rekomendujące treści, jest efekt potwierdzenia (ang. confirmation bias): w serwisie widzimy tylko treści odpowiadające naszym przekonanion i przesądom, i stajemy się odizolowani od argumentów przeciwnych, por. trailer filmu "The Social Dilemma". Algorytmy realizujące te założenia od dziesięcioleci okazały się na tyle efektywne, że na długo przed SI doprowadziły do polaryzacji społeczeństw przez tworzenie tzw. baniek informacyjnych.

2. Algorytmy poznają nasze słabości

Mikrotargetowanie (ang. microtargeting) to kolejny — z pozoru niewinny — mechanizm, zwiększający efektywność reklam. Oczywistym wydaje się, że nie ma sensu wyświetlanie reklam nowych modeli samochodów osobom, które nie mają prawa jazdy, lub w ogóle nie interesują się samochodami. Skąd algorytmy wiedzą, co interesuje konkretne osoby? Pokazał to Michał Kosiński:

(...) Według jego badań algorytm ten jest w stanie określić preferencje seksualne (u mężczyzn skutecznie w 88% przypadków), wygląd, zainteresowania, poziom inteligencji, pochodzenie etniczne i kolor skóry (u Amerykanów skutecznie w 95% przypadków), wyznanie, poziom zadowolenia z życia, uzależnienia, wiek, płeć oraz poglądy społeczne, religijne i polityczne (...) na podstawie 68 polubień na Facebooku.[2]

Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. historia Cambridge Analitica i film "The Great Hack" (trailer).

3. SI upraszcza fałszerstwa na wielką skalę

W ostatnich dzisięcioleciach cyberwojna w przestrzeni mediów społecznościowych prowadzona była przez duże i finansowane przez rządy przedsiębiorstwa, jak np. farma trolli założona przez Prigożyna w Petersburgu. Setki pracowników pisały setki blogów i komentarzy nakierowanych na powielanie rosyjskiej narracji, rozprzestrzenianie fałszywych informacji, wywoływanie skrajnych postaw społecznych i politycznych oraz dezinformowanie zagranicznej opinii publicznej (...)[3].

Tych urzędników może zastąpić sztuczna inteligencja. Zamiast siermiężnych tekstów, pełnych błędów językowych i łatwych do rozpoznania, pozwala tanio i masowo produkować błyskotliwe, inteligentne i pisane doskonałym językiem kłamstwa na dowolnie wybrany temat, poparte tyleż przekonywującymi co fałszywymi zdjęciami i filmami. Jeśli dodamy do tego wspomniany powyżej mikrotargeting, nieodróżnialne i liczniejsze od ludzi boty o "bardzo podobnych do naszych przekonaniach i obawach" opanują cybeprzestrzeń i będą w stanie przekonać nas do dowolnie wybranej przez mocodawców bzdury — albo też ostatecznie podważą zaufanie do komunikacji elektronicznej.

- ↑ Adam Mickiewicz, Dziady, część III "Wielka Improwizacja":

(...) Daj mi rząd dusz! - Tak gardzę tą martwą budową,

Którą gmin światem zowie i przywykł ją chwalić,

Żem nie próbował dotąd, czyli moje słowo

Nie mogłoby jej wnet zwalić. (...) - ↑ https://pl.wikipedia.org/wiki/Michał_Kosiński

- ↑ https://pl.wikipedia.org/wiki/Agencja_Badań_Internetowych