TI/Media społecznościowe: Różnice pomiędzy wersjami

| Linia 10: | Linia 10: | ||

W roku 2021 firma Facebook nabyła, wraz z prawami do headsetu [https://en.wikipedia.org/wiki/Oculus_Rift Oculus], firmę Oculus VR, stworzoną przez Palmera Luckey (który następnie w 2017 założył firmę [https://en.wikipedia.org/wiki/Anduril_Industries Anduril]), a w 2021 wręcz zmieniła nazwę na "Meta", aby podkreślić zaangażowanie w urzeczywistnienie wizji [https://en.wikipedia.org/wiki/Metaverse Metaverse], przedstawionej w 1992 roku w książce Neala Stephensona [https://pl.wikipedia.org/wiki/Zamieć_(powieść_Neala_Stephensona) ''Snow Crash'']. | W roku 2021 firma Facebook nabyła, wraz z prawami do headsetu [https://en.wikipedia.org/wiki/Oculus_Rift Oculus], firmę Oculus VR, stworzoną przez Palmera Luckey (który następnie w 2017 założył firmę [https://en.wikipedia.org/wiki/Anduril_Industries Anduril]), a w 2021 wręcz zmieniła nazwę na "Meta", aby podkreślić zaangażowanie w urzeczywistnienie wizji [https://en.wikipedia.org/wiki/Metaverse Metaverse], przedstawionej w 1992 roku w książce Neala Stephensona [https://pl.wikipedia.org/wiki/Zamieć_(powieść_Neala_Stephensona) ''Snow Crash'']. | ||

| − | |||

===Wpływ na wolność decyzji=== | ===Wpływ na wolność decyzji=== | ||

| − | Choć korzystanie z tych serwisów jest najczęściej darmowe, nie są one bynajmniej prowadzone przez organizacje non-profit. Dla zwiększenia zysku z reklam celowanych do konkretnych grup odbiorców, dopasowanych do ich preferencji i słabości ([https://en.wikipedia.org/wiki/Microtargeting microtargeting]), oraz ze sprzedaży informacji o użytkownikach, firmy prowadzące te serwisy implementują algorytmy zwiększające "zaangażowanie" użytkowników, czyli czas spędzany w serwisie. Osiągane jest to zwykle przez rekomendowanie (filtrowanie spośród dostępnych) treści, maksymalizujących prawdopodobieństwo wywołania zainteresowania danego użytkownika — ponownie dzięki znajomości jego preferencji i słabości. | + | Choć korzystanie z tych serwisów jest najczęściej darmowe, nie są one bynajmniej prowadzone przez organizacje non-profit. Dla zwiększenia zysku z reklam celowanych do konkretnych grup odbiorców, dopasowanych do ich preferencji i słabości ([https://en.wikipedia.org/wiki/Microtargeting microtargeting]), oraz ze sprzedaży informacji o użytkownikach, firmy prowadzące te serwisy implementują algorytmy zwiększające "zaangażowanie" użytkowników, czyli czas spędzany w serwisie. Osiągane jest to zwykle przez rekomendowanie (filtrowanie spośród dostępnych) treści, maksymalizujących prawdopodobieństwo wywołania zainteresowania danego użytkownika — ponownie dzięki znajomości jego preferencji i słabości. |

| − | |||

Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. [https://en.wikipedia.org/wiki/Facebook–Cambridge_Analytica_data_scandal historia Cambridge Analitica] i film "The Great Hack" ([https://youtu.be/iX8GxLP1FHo trailer]). | Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. [https://en.wikipedia.org/wiki/Facebook–Cambridge_Analytica_data_scandal historia Cambridge Analitica] i film "The Great Hack" ([https://youtu.be/iX8GxLP1FHo trailer]). | ||

| − | |||

| Linia 28: | Linia 25: | ||

| + | ===Bańki informacyjne=== | ||

| + | Kolejną regułą, którą bez trudu "odkrywają" algorytmy rekomendujące treści, jest [https://pl.wikipedia.org/wiki/Efekt_potwierdzenia efekt potwierdzenia] (ang. ''confirmation bias''). Algorytmy realizujące te założenia od dziesięcioleci okazały się na tyle efektywne, że (na długo przed SI) doprowadziły do polaryzacji społeczeństw przez tworzenie tzw. [https://pl.wikipedia.org/wiki/Bańka_filtrująca baniek informacyjnych]: w serwisie widzimy tylko treści odpowiadające naszym przekonanion i przesądom, i stajemy się odizolowani od argumentów przeciwnych, por. [https://youtu.be/uaaC57tcci0 trailer filmu "The Social Dilemma"] | ||

| − | |||

| − | |||

Wersja z 17:06, 23 wrz 2024

Spis treści

⬆ WWW vs. media społecznościowe

WWW powstał w latach 90. ubiegłego wieku jako medium z założenia dwukierunkowe: pierwsze przeglądarki miały wbudowane edytory HTML, aby każdy użytkownik mógł zarówno przeglądać jak i tworzyć treści. Pomimo tego, Internet upodobnił się dość szybko do innych mediów, w których treści tworzone są przez profesjonalne, komercyjne zepoły, a większość użytkowników tylko je ogląda — niezależnie od faktu, że do dzisiaj każdy ma możliwość stworzenia własnej strony WWW i samodzielnego udostępniania własnych treści (w granicach prawa).

Zmianę tego modelu przyniosły dopiero na początku wieku idee Web 2.0, których najpopularniejszą implementacją stały się media społecznościowe. Choć formalnie można odróżniać media od serwisów czy platform społecznościowych, klasyfikować osobno serwisy nakierowane na udostępnianie filmów, zdjęć czy ogólnie tworzenie sieci społecznych itp., tu rówmnież możemy podejść do definicji zgodnie ze staropolskim "Koń jaki jest, każdy widzi" — wiadomo, że chodzi o Facebooka, Instagrama, Twittera (aktualnie X), YouTube, TikToka, WeChat (w Chinach) itp.

Aby przyciągnąć użytkowników, serwisy oferują coraz więcej podobnych funkcji, przez co do mediów społecznościowych coraz częściej zaliczane są też komunikatory takie jak WhatsApp czy Telegram, umożliwiające publikowanie treści potencjalnie dostępnych dla każdego użytkownika danego serwisu.

Media społecznościowe oferują dużo łatwiejszy sposób publikowania, oznaczania, oraz funkcje mierzące popularność treści. Ceną za te udogodnienia jest, że wszystkie te treści znajdować się muszą na sewerach firmy udostępniającej dany serwis, oraz — mniej lub bardziej, zależnie od regulaminów — stają się własnością firm te serwisy prowadzących. To najważniejsza różnica w porównaniu do publikowania treści na własnych stronach WWW.

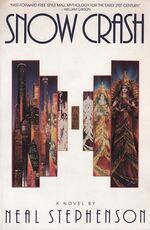

W roku 2021 firma Facebook nabyła, wraz z prawami do headsetu Oculus, firmę Oculus VR, stworzoną przez Palmera Luckey (który następnie w 2017 założył firmę Anduril), a w 2021 wręcz zmieniła nazwę na "Meta", aby podkreślić zaangażowanie w urzeczywistnienie wizji Metaverse, przedstawionej w 1992 roku w książce Neala Stephensona Snow Crash.

Wpływ na wolność decyzji

Choć korzystanie z tych serwisów jest najczęściej darmowe, nie są one bynajmniej prowadzone przez organizacje non-profit. Dla zwiększenia zysku z reklam celowanych do konkretnych grup odbiorców, dopasowanych do ich preferencji i słabości (microtargeting), oraz ze sprzedaży informacji o użytkownikach, firmy prowadzące te serwisy implementują algorytmy zwiększające "zaangażowanie" użytkowników, czyli czas spędzany w serwisie. Osiągane jest to zwykle przez rekomendowanie (filtrowanie spośród dostępnych) treści, maksymalizujących prawdopodobieństwo wywołania zainteresowania danego użytkownika — ponownie dzięki znajomości jego preferencji i słabości. Zastosowanie technik manipulacji behawioralnej w marketingu politycznym umożliwiło ogromny wpływ na wyniki wyborów i referendów, których obiektywność stanowi fundament demokracji — por. historia Cambridge Analitica i film "The Great Hack" (trailer).

Algorytmy rekomendujące treści: "niewinne" cele i tragiczne skutki

Kolejnym, zupełnie nieoczekiwanym problemem, są skutki działania algorytmów nastawionych na optymalizację zaangażowania użytkowników, czyli, prościej mówiąc, czasu spędzanego w danej aplikacji. Cel wydaje się oczywisty i znany — dokładnie tak samo od dziesięcioleci stacje telewizyjne maksymalizują "oglądalność", bo jeśli stację ogląda więcej widzów, to emitowane w niej reklamy dotrą do większej liczby odbiorców, więc czas reklamowy jest więcej wart, co podnosi zyski itd. Jednak w tradycyjnych mediach za wyświetlane treści odpowiadają firmy — stacje telewizyjne, radiowe, redakcje gazet. Ich wpływ na opinie społeczeństwa jest ogromny, co wiemy od dziesięcioleci, stąd np. pojęcie etyki dziennikarskiej.

W mediach społecznościowych twórcami treści są użytkownicy. W braku "redaktora naczelnego" w tych mediach pojawiają się treści zarówno mądre, wartościowe, prawdziwe jak też kompletnie bzdurne lub, co gorsza, świadomie fałszowane. Które z tych treści będą nam podsuwać algorytmy, maksymalizująca zaangażowanie? Od tego zależy ich widoczność, popularność, i wpływ na użytkowników!

Propagowanie, czyli podpowiadanie/podsuwanie treści najmocniej oddziałujących na niskie uczucia (obrazy przemocy, teorie spiskowe) prowadzi do tragedii takich jak masakra ludu Rohingya w Myanmar (dawniej Birma), wynikła w dużej części z rozpropagowania mowy nienawiści buddyjskiego mnicha Ashina Wirathu, którego posty szkalujące Rohingya były powielane bez porównania mocniej niż opinie mnichów wzywających do współczucia.

Bańki informacyjne

Kolejną regułą, którą bez trudu "odkrywają" algorytmy rekomendujące treści, jest efekt potwierdzenia (ang. confirmation bias). Algorytmy realizujące te założenia od dziesięcioleci okazały się na tyle efektywne, że (na długo przed SI) doprowadziły do polaryzacji społeczeństw przez tworzenie tzw. baniek informacyjnych: w serwisie widzimy tylko treści odpowiadające naszym przekonanion i przesądom, i stajemy się odizolowani od argumentów przeciwnych, por. trailer filmu "The Social Dilemma"