WnioskowanieStatystyczne/Regresja liniowa: Różnice pomiędzy wersjami

| Linia 6: | Linia 6: | ||

Pary pomiarów <math>(x_{i},y_{i})</math>. Dla każdego | Pary pomiarów <math>(x_{i},y_{i})</math>. Dla każdego | ||

| − | <math>x_{i},y_{i}</math> traktujemy jak zmienną losową z rozkładu | + | <math>x_{i}</math>, <math>y_{i}</math> traktujemy jak zmienną losową z rozkładu |

normalnego o wartości średniej <math>a+b</math> <math>x_{i}</math> i wariancji <math>\sigma _{i}^{2}</math>. Prawdopodobieństwo | normalnego o wartości średniej <math>a+b</math> <math>x_{i}</math> i wariancji <math>\sigma _{i}^{2}</math>. Prawdopodobieństwo | ||

''a posteriori'' otrzymania <math>N</math> wyników <math>y_{i}</math> | ''a posteriori'' otrzymania <math>N</math> wyników <math>y_{i}</math> | ||

| Linia 130: | Linia 130: | ||

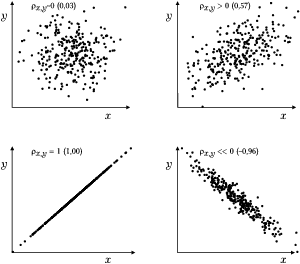

| − | [[Plik:Korelacja.png| | + | [[Plik:Korelacja.png|600px|thumb|left|<figure id="fig:rozw2"></figure>Przykładowe wartości współczynnika korelacji dla 300 par <math>(x, y)</math> o |

różnych stopniach współzależności. | różnych stopniach współzależności. | ||

]] | ]] | ||

Wersja z 19:11, 20 kwi 2017

Wnioskowanie_Statystyczne_-_wykład

Regresja liniowa

Pary pomiarów [math](x_{i},y_{i})[/math]. Dla każdego [math]x_{i}[/math], [math]y_{i}[/math] traktujemy jak zmienną losową z rozkładu normalnego o wartości średniej [math]a+b[/math] [math]x_{i}[/math] i wariancji [math]\sigma _{i}^{2}[/math]. Prawdopodobieństwo a posteriori otrzymania [math]N[/math] wyników [math]y_{i}[/math] dla określonych [math]x_{i}[/math] przy założeniu wartości [math]a[/math] i [math]b[/math]

[math] P(\overline{y}\mid \overline{x},a,b)=\underset{i=1}{\overset{N}{\prod }} \frac{1}{\sqrt{2\pi \sigma _{i}^{2}}}e^{\frac{(y_{i}-a-bx_{i})^{2}}{2\sigma _{i}^{2}}}=\frac{1}{\sqrt{(2\pi )^{n}}}\underset{i=1}{\overset{N}{\prod }} \frac{1}{\sigma _{i}}e^{-\frac{1}{2}\underset{i=1}{\overset{N}{\sum }}\frac{ (y_{i}-a-bx_{i})^{2}}{\sigma _{i}^{2}}} [/math]

logarytmiczna [math]\rightarrow[/math] funkcja wiarygodności:

[math] l=-\frac{N}{2}\ln 2\pi +\ln (\underset{i=1}{\overset{N}{\prod }}\frac{1}{ \sigma _{i}})-\frac{1}{2}\underset{i=1}{\overset{N}{\sum }}\frac{ (y_{i}-a-bx_{i})^{2}}{\sigma _{i}^{2}} [/math]

[math]\sigma _{i}[/math] zwykle nie znamy, możemy przyjąć [math]\forall i \sigma _{i}=\sigma[/math]. Pozostaje szukanie minimum sumy [math]S=\underset{i=1}{\overset{N}{\sum }}(y_{i}-a-bx_{i})^{2}[/math], w zerze pochodnej po parametrach [math]a[/math] i [math]b[/math]

[math] \frac{\partial S}{\partial a}=-2\underset{i=1}{\overset{N}{\sum }} (y_{i}-a-bx_{i}),\ \ \ \ \ \ \ \ \frac{\partial S}{\partial b}=-2\underset{}{ \underset{i=1}{\overset{N}{\sum }}x_{i}}(y_{i}-a-bx_{i}), \dots [/math]

[math] D=N\underset{i=1}{\overset{N}{\sum }}x_{i}^{2}-\left( \underset{i=1}{ \overset{N}{\sum }}x_{i}\right) ^{2} [/math]

[math] a=\frac{\underset{i=1}{\overset{N}{\sum }}y_{i}\underset{i=1}{\overset{N}{\sum }}x_{i}^{2}-\underset{i=1}{\overset{N}{\sum }}x_{i} \underset{i=1}{\overset{N}{\sum }}x_{i}y_{i}}{D}, \qquad b=\frac{N\underset{i=1}{\overset{N}{\sum }}x_{i}y_{i}-\left( \underset{i=1}{\overset{N}{\sum }}x_{i}\right) \left( \underset{i=1}{\overset{N}{\sum }} y_{i}\right) }{D} [/math]

lub:

[math] b=\frac{\underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x})(y_{i}- \overline{y})}{\underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x})^{2}}, \qquad a=\overline{y}-b\overline{x} [/math]

Interpretacja współczynnika korelacji

Rozważmy wariancję zmiennej [math]y[/math] z poprzedniego rozdziału. Niech [math]y_{i}^{p}=a+bx_{i}[/math]

[math] \underset{i=1}{\overset{N}{\sum }}(y_{i}-\overline{y})^{2}= \underset{i=1}{\overset{N}{\sum }}(y_{i}-y_{i}^{p}+y_{i}^{p}-\overline{y} )^{2}= [/math] [math] \underset{i=1}{\overset{N}{\sum }}(y_{i}-y_{i}^{p})^{2}+\underset{i=1}{ \overset{N}{\sum }}(y_{i}^{p}-\overline{y})^{2}+2\underset{i=1}{\overset{N}{ \sum }}(y_{i}-y_{i}^{p})(y_{i}^{p}-\overline{y}) [/math]

Całkowitą wariancię zmiennej [math]y[/math] podzieliliśmy na dwa człony: wariancję estymaty [math]y_{i}^{p}[/math] wokół wartości średniej [math]\overline{y}[/math] i wariancję obserwowanych [math]y_{i}[/math] wokół estymaty [math]y_{i}^{p}[/math] (trzeci człon znika).

Współczynnik korelacji

[math]

\rho_{x, y}= \frac{\sigma_{x, y}}{\sigma_x \sigma_y}=

\frac{E\left( \left(x-\mu_{x})(y-\mu_{y}\right)\right)}

{\sqrt{E\left( (x-\mu_{x})^2\right) E\left( (y-\mu_{y})^2\right)}},

[/math]

możemy estymować jako

[math] \rho ^{2}=\frac{\left( \underset{i=1}{\overset{N}{\sum }}(x_{i}- \overline{x})(y_{i}-\overline{y})\right) ^{2}}{\underset{i=1}{\overset{N}{ \sum }}(x_{i}-\overline{x})^{2}\underset{i=1}{\overset{N}{\sum }}(y_{i}- \overline{y})^{2}} [/math]

Rozważmy

[math] { \underset{i=1}{\overset{N}{\sum }}(y_{i}^{p}-\overline{y})^{2}=b^{2} \underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x})^{2}=\frac{\left( \underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x})(y_{i}-\overline{y} )\right) ^{2}}{\left( \underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x} )^{2}\right) ^{2}}\underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x} )^{2}=\ } [/math]

[math] { =\frac{\left( \underset{i=1}{\overset{N}{\sum }}(x_{i}-\overline{x} )(y_{i}-\overline{y})\right) ^{2}}{\underset{i=1}{\overset{N}{\sum }}(x_{i}- \overline{x})^{2}}\frac{\underset{i=1}{\overset{N}{\sum }}(y_{i}-\overline{y} )^{2}}{\underset{i=1}{\overset{N}{\sum }}(y_{i}-\overline{y})^{2}}=\rho ^{2} \underset{i=1}{\overset{N}{\sum }}(y_{i}-\overline{y})^{2}\ } [/math]

czyli

[math] { \rho ^{2}=\frac{\underset{i=1}{\overset{N}{\sum }}(y_{i}^{p}- \overline{y})^{2}}{\underset{i=1}{\overset{N}{\sum }}(y_{i}-\overline{y})^{2} }\ } [/math]