Model autoregresyjny (AR): Różnice pomiędzy wersjami

| (Nie pokazano 66 pośrednich wersji utworzonych przez tego samego użytkownika) | |||

| Linia 1: | Linia 1: | ||

| − | + | =[[Analiza_sygnałów_-_lecture|AS/]] Model autoregresyjny (AR)= | |

Model autoregresyjny (rzędu <math>M</math>) opisuje procesy dyskretne, | Model autoregresyjny (rzędu <math>M</math>) opisuje procesy dyskretne, | ||

w których wartość sygnału w danej chwili jest sumą liniowej | w których wartość sygnału w danej chwili jest sumą liniowej | ||

kombinacji <math>M</math> wartości poprzednich i nieskorelowanego szumu <math>\epsilon</math> | kombinacji <math>M</math> wartości poprzednich i nieskorelowanego szumu <math>\epsilon</math> | ||

| − | <equation id="eq:41"> | + | |

| + | |||

| + | ::::::<equation id="eq:41"> | ||

<math> | <math> | ||

| − | s[n] = \sum_{i=1}^M a_i s[n-i] + \ | + | \displaystyle |

| + | s[n] = \sum_{i=1}^M a_i s[n-i] + \epsilon[n] | ||

</math> | </math> | ||

</equation> | </equation> | ||

| + | |||

W każdej realizacji tego samego procesu (dla tych samych | W każdej realizacji tego samego procesu (dla tych samych | ||

| Linia 16: | Linia 20: | ||

prawdopodobieństwa. | prawdopodobieństwa. | ||

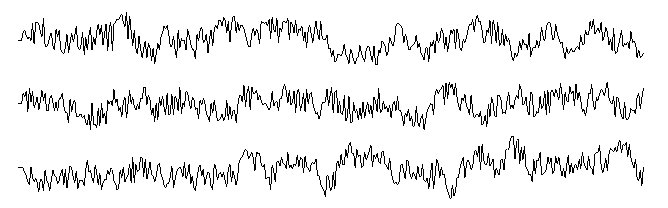

| − | [[Plik:klasyczna_rys_6.jpg|thumb|center| | + | [[Plik:klasyczna_rys_6.jpg|thumb|668px|center|Trzy przykładowe realizacje procesu AR 3-go rzędu (<math>M=3</math>) o tych samych współczynnikach i wartościach początkowych.]] |

Mimo tego, na podstawie współczynników AR możemy określić wiele | Mimo tego, na podstawie współczynników AR możemy określić wiele | ||

| Linia 26: | Linia 30: | ||

gdzie uśredniamy <math>\epsilon_t</math> zamiast <math>s(t)</math>, czy proces mieszany ARMA, opisany między innymi w klasycznych pozycjach [http://eu.wiley.com/WileyCDA/WileyTitle/productCd-0470272848.html „Analizie szeregów czasowych”, autorstwa Boxa i Jenkinsa] oraz w [http://books.google.pl/books?id=iu7pq6_vo3QC&pg=PA527&lpg=PA527&dq=piersol+bendat+wiley&source=bl&ots=tBsERShrXL&sig=I078ZjLwiw8BBHqrnzhVfbm5H8I&hl=pl&ei=WWuqS9rEEKbSmgOs_82IAg&sa=X&oi=book_result&ct=result&resnum=10&ved=0CDwQ6AEwCQ#v=onepage&q=piersol%20bendat%20wiley&f=false „Metodach analizy szeregów czasowych” autorstwa Piersola i Bendata]. | gdzie uśredniamy <math>\epsilon_t</math> zamiast <math>s(t)</math>, czy proces mieszany ARMA, opisany między innymi w klasycznych pozycjach [http://eu.wiley.com/WileyCDA/WileyTitle/productCd-0470272848.html „Analizie szeregów czasowych”, autorstwa Boxa i Jenkinsa] oraz w [http://books.google.pl/books?id=iu7pq6_vo3QC&pg=PA527&lpg=PA527&dq=piersol+bendat+wiley&source=bl&ots=tBsERShrXL&sig=I078ZjLwiw8BBHqrnzhVfbm5H8I&hl=pl&ei=WWuqS9rEEKbSmgOs_82IAg&sa=X&oi=book_result&ct=result&resnum=10&ved=0CDwQ6AEwCQ#v=onepage&q=piersol%20bendat%20wiley&f=false „Metodach analizy szeregów czasowych” autorstwa Piersola i Bendata]. | ||

| − | Najprostszym przykładem jest proces AR pierwszego rzędu (nazywany | + | |

| + | ==AR(1)== | ||

| + | Najprostszym przykładem jest proces AR pierwszego rzędu (nazywany łańcuchem Markowa), w którym wartość w danej chwili zależy wyłącznie od wartości w chwili poprzedniej i szumu: | ||

<math> | <math> | ||

s[n] = a s[n-1] + \epsilon_n | s[n] = a s[n-1] + \epsilon_n | ||

| + | </math>; | ||

| + | podstawiając trzy kolejne wyrazy | ||

| + | |||

| + | |||

| + | <math>s[n] = \epsilon_n + a s[n-1] </math> | ||

| + | |||

| + | |||

| + | <math>s[n-1] = \epsilon_{n-1} + a s[n-2] </math> | ||

| + | |||

| + | |||

| + | <math>s[n-2] = \epsilon_{n-2} + a s[n-3]</math> | ||

| + | |||

| + | |||

| + | dostaniemy | ||

| + | |||

| + | |||

| + | <math> | ||

| + | s[n] = | ||

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \epsilon_n + a s[n-1] = | ||

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \epsilon_n + a \left( \epsilon_{n-1} + a s[n-2] \right) = | ||

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \epsilon_n + a \left( \epsilon_{n-1} + a (\epsilon_{n-2} + a s[n-3]) \right) = | ||

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \epsilon_n + a \epsilon_{n-1} + a^2 \epsilon_{n-2} + a^3 s[n-3] | ||

| + | </math> | ||

| + | |||

| + | |||

| + | W ogólnym przypadku <math>N</math> wyrazów będzie to suma | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \displaystyle | ||

| + | s[n] = \sum_{i=0}^{N-1} a^i \epsilon_{n-i} + a^N s[n-N] | ||

</math> | </math> | ||

| − | + | ||

| − | s[n] = \epsilon_n + a | + | Dla <math>N \rightarrow \infty</math> zależność od pierwszego elementu <math>s[n-N]</math> zanika i dostajemy asymptotyczną reprezentację |

| − | + | ||

| + | |||

| + | <math> \displaystyle | ||

| + | s[n] = \epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2} +\ldots = \sum_{i=0}^{\infty} a^i \epsilon_{n-i} | ||

</math> | </math> | ||

| + | |||

Jeśli wartość oczekiwana <math>\epsilon_i</math> wynosi 0 (<math>E(\epsilon_i)=0</math>) a wariancja | Jeśli wartość oczekiwana <math>\epsilon_i</math> wynosi 0 (<math>E(\epsilon_i)=0</math>) a wariancja | ||

| − | <math>\sigma^2(\epsilon_i)=\sigma_\epsilon^2</math>, to wariancja w punkcie <math>n</math> | + | <math>\sigma^2(\epsilon_i)=\sigma_\epsilon^2</math>, to wariancja <math>s[n]</math> w punkcie <math>n</math> |

| + | |||

| − | <math>\begin{matrix} | + | <math>\displaystyle |

| + | \begin{matrix} | ||

\sigma^2_{s[n]} = E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1)^2\right) =\\ | \sigma^2_{s[n]} = E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1)^2\right) =\\ | ||

| + | \\ | ||

= \sigma_\epsilon^2 \left(1+a^2+a^4+\ldots+a^{2n-2} \right) = | = \sigma_\epsilon^2 \left(1+a^2+a^4+\ldots+a^{2n-2} \right) = | ||

\left\{ | \left\{ | ||

| Linia 49: | Linia 109: | ||

\right. | \right. | ||

\end{matrix}</math> | \end{matrix}</math> | ||

| + | |||

| + | |||

| + | bo | ||

| + | |||

| + | <math> | ||

| + | \sum_{k=1}^n b q^{k-1} = \left\{ \begin{matrix}b \frac{1 - q^n}{1 - q} \;\;\;\; \textrm{ dla }\;\;\;q\ne 1,\\ | ||

| + | n b \;\;\;\;\;\;\;\;\; \textrm{ dla }\;\;\;\; q = 1. | ||

| + | \end{matrix} | ||

| + | \right. | ||

| + | </math> | ||

| + | |||

| + | |||

| + | |||

Autokowariancja <math>E(s[n] s[n+\tau])</math> | Autokowariancja <math>E(s[n] s[n+\tau])</math> | ||

| − | <math>\begin{matrix} | + | |

| + | <math> | ||

| + | \displaystyle | ||

| + | \begin{matrix} | ||

E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1) | E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1) | ||

(\epsilon_{n+\tau} + a\epsilon_{n+\tau-1} | (\epsilon_{n+\tau} + a\epsilon_{n+\tau-1} | ||

| − | |||

+\ldots+a^{n+\tau-1}\epsilon_1)\right) =\\ | +\ldots+a^{n+\tau-1}\epsilon_1)\right) =\\ | ||

| + | \\ | ||

= \sigma_\epsilon^2 \left(a^\tau+a^{\tau+2}+\ldots+a^{\tau+2(n-1)} \right) = | = \sigma_\epsilon^2 \left(a^\tau+a^{\tau+2}+\ldots+a^{\tau+2(n-1)} \right) = | ||

\left\{ | \left\{ | ||

| Linia 64: | Linia 140: | ||

\end{matrix} | \end{matrix} | ||

\right. | \right. | ||

| − | \end{matrix}</math> | + | \end{matrix} |

| + | </math> | ||

| + | |||

| + | |||

| + | |||

Dla <math>|a|\ne 1</math> przy <math>n\rightarrow\infty</math> | Dla <math>|a|\ne 1</math> przy <math>n\rightarrow\infty</math> | ||

| − | <math> | + | <math>\displaystyle |

\sigma^2_{x[n]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon}{1-a^2} \;\;\; ; \;\;\; | \sigma^2_{x[n]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon}{1-a^2} \;\;\; ; \;\;\; | ||

\sigma_{x[n], x[n+\tau]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon a^\tau}{1-a^2} | \sigma_{x[n], x[n+\tau]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon a^\tau}{1-a^2} | ||

</math> | </math> | ||

| + | |||

Autokowariancja | Autokowariancja | ||

| + | |||

| + | |||

<math> | <math> | ||

| + | \displaystyle | ||

\rho(\tau) = \frac{ \sigma_{x[n], x[n+\tau]} }{ \sigma^2_{x[n]} } \stackrel{n\rightarrow\infty}{\longrightarrow} a^{|\tau|} | \rho(\tau) = \frac{ \sigma_{x[n], x[n+\tau]} }{ \sigma^2_{x[n]} } \stackrel{n\rightarrow\infty}{\longrightarrow} a^{|\tau|} | ||

</math> | </math> | ||

| − | Proces jest asymptotycznie stacjonarny do rzędu 2, czyli wariancja | + | |

| − | i średnia nie zależą od czasu. | + | Proces jest '''asymptotycznie stacjonarny do rzędu 2''', czyli wariancja i średnia nie zależą od czasu. |

Dla <math>a=1</math> proces ten obrazuje tzw. błądzenie przypadkowe. | Dla <math>a=1</math> proces ten obrazuje tzw. błądzenie przypadkowe. | ||

| Linia 84: | Linia 168: | ||

Na podstawie znajomości samego współczynnika <math>a</math> modelu | Na podstawie znajomości samego współczynnika <math>a</math> modelu | ||

AR(1) policzyliśmy np. funkcję autokorelacji modelu, co daje już | AR(1) policzyliśmy np. funkcję autokorelacji modelu, co daje już | ||

| − | znajomość widma procesu | + | znajomość widma procesu (z przytoczonego poniżej |

| − | + | twierdzenia Wienera-Chinczyna). Podobnie w procesach wyższych rzędów <xr | |

| − | |||

id="eq:41">(%i)</xr> znajomość współczynników | id="eq:41">(%i)</xr> znajomość współczynników | ||

<math>\{a_i\}_{i=1..M}</math> daje nam dokładną wiedzę o własnościach | <math>\{a_i\}_{i=1..M}</math> daje nam dokładną wiedzę o własnościach | ||

| Linia 99: | Linia 182: | ||

do danego sygnału posiada stabilne rozwiązania. | do danego sygnału posiada stabilne rozwiązania. | ||

| + | <!-- | ||

Jeśli dozwolimy, aby sygnał zależał również bezpośrednio od | Jeśli dozwolimy, aby sygnał zależał również bezpośrednio od | ||

poprzednich wartości szumu <math>\epsilon</math>, dostajemy pełną | poprzednich wartości szumu <math>\epsilon</math>, dostajemy pełną | ||

| Linia 108: | Linia 192: | ||

</math> | </math> | ||

</equation> | </equation> | ||

| + | --> | ||

| + | |||

| + | ==Twierdzenie Wienera-Chinczyna== | ||

| + | Transformata Fouriera funkcji autokorelacji jest równa kwadratowi modułu transformaty Fouriera. | ||

| + | |||

| + | ''Dowód'' | ||

| − | === | + | Kładąc <math>f = g</math> [[Twierdzenia_o_splocie_i_o_próbkowaniu_(aliasing)#label-eq:29|we wzorze na funkcję korelacji sygnałów ''f'' i ''g'']], dostajemy analogznie jak poprzednio |

| + | |||

| + | <math display="block"> | ||

| + | \displaystyle | ||

| + | \mathcal{F} \left( \int_{-\infty}^{\infty} f(t) f(t+\tau) dt \right) = | ||

| + | </math> | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

<math> | <math> | ||

| − | \ | + | \displaystyle |

| − | </math> | + | \int_{-\infty}^{\infty} e^{-i\omega \tau} \left( \int_{-\infty}^{\infty} f(t) f(t+\tau) dt \right) d\tau = |

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \displaystyle | ||

| + | \int_{-\infty}^{\infty} e^{-i\omega(t+\tau)} e^{i\omega t} \int_{-\infty}^{\infty} f(t) f(t+\tau) dt d\tau = | ||

| + | </math> | ||

| + | |||

| + | |||

| + | <math> | ||

| + | \displaystyle | ||

| + | \int_{-\infty}^{\infty} e^{-i\omega(t+\tau)} f(t+\tau) d\tau \int_{-\infty}^{\infty} e^{i\omega t} f(t) dt = | ||

| + | </math> | ||

| − | |||

| − | |||

| − | |||

<math> | <math> | ||

| − | \ | + | \displaystyle |

| − | </math> | + | \hat{f}(\omega) \overline{\hat{f}(\omega)} = |\hat{f}(\omega)|^2 |

| + | </math> | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | |||

| + | == Estymacja współczynników AR i kryterium Akaike'go== | ||

| + | |||

| + | Najtrudniejszym krokiem w estymacji współczynników modelu AR jest wybór rzędu <math>M</math>, czyli pamięci modelu. Pomagają w tym kryteria, których przykładem jest Akaike Information Criterion AIC: | ||

| + | |||

| + | |||

| + | :::::<math>\displaystyle | ||

| + | \mathrm{AIC}(M)= \frac{2M}{N} + \ln(\sigma^2_{\epsilon}) </math> | ||

| + | |||

| + | |||

| + | gdzie <math>N</math> - liczba próbek sygnału. Kryterium to karze za zwiększanie liczby parametrów i nagradza za zmniejszanie niewytłumaczonej wariancji. | ||

| + | |||

| + | ==Parametryczna estymacja widma mocy sygnałów== | ||

| + | |||

| + | Pokazaliśmy powyżej (na przykładzie błądzenia przypadkowego), że znając współczynniki (parametry) modelu AR możemy z nich wyliczyć funkcję autokorelacji odpowiadającego im procesu, bez znajomości konkretnej realizacji sygnału. Z kolei z funkcji autokorelacji możemy z pomocą powyższego twierdzenia '''obliczyć''' widmo. To widmo będzie wyliczone a nie estymowane, ale nie odnosi się bezpośrednio do sygnału, od którego zaczynaliśmy, tylko do procesu opisanego '''wyestymowanymi''' parametrami modelu AR. | ||

| + | |||

| + | Ogólnie w statystyce mówimy o: | ||

| + | * estymacji parametrycznej jako znajdowaniu nieznanych wartości parametrów rozkładu, oraz | ||

| + | * estymacji nieparametrycznej jako metodzie znajdowania postaci rozkładu populacji (analogicznie do [https://brain.fuw.edu.pl/edu/index.php/WnioskowanieStatystyczne/Testy_nieprametryczne testów nieparametrycznych]). | ||

| + | |||

| + | Na przykład dla stu obserwacji, co do których zakładamy, że pochodzą z rozkładu normalnego, możemy znaleźć średnią i wariancję (parametry rozkładu) i na tej podstawie estymować prawdopodobieństwo w dowolnym przedziale. Jeśli nie chcemy zakładać postaci rozkładu, nieparametryczną estymatą ''n''-tego percentyla będzie największy z pierwszych ''n'' wyników (dla próby o liczności 100). | ||

<references/> | <references/> | ||

| + | |||

| + | |||

| + | |||

| + | <div align="right"> | ||

| + | [[Systemy_liniowe_niezmiennicze_w_czasie_(LTI)|⬅]] [[Analiza_sygnałów_-_wykład|⬆]] [[Funkcja_systemu|⮕]] | ||

| + | </div> | ||

Wersja z 07:54, 23 lip 2024

Spis treści

AS/ Model autoregresyjny (AR)

Model autoregresyjny (rzędu [math]M[/math]) opisuje procesy dyskretne, w których wartość sygnału w danej chwili jest sumą liniowej kombinacji [math]M[/math] wartości poprzednich i nieskorelowanego szumu [math]\epsilon[/math]

- [math] \displaystyle s[n] = \sum_{i=1}^M a_i s[n-i] + \epsilon[n] [/math]

W każdej realizacji tego samego procesu (dla tych samych

współczynników [math]a_i[/math] i wartości początkowych sygnału), [math]\epsilon_t[/math]

są niezależnymi liczbami losowymi, więc o wartości [math]s(t)[/math] w

konkretnej chwili [math]t[/math] możemy mówić tylko językiem

prawdopodobieństwa.

Mimo tego, na podstawie współczynników AR możemy określić wiele ogólnych własności sygnału, np. wartość oczekiwaną [math]\bar{s}[/math] (w praktyce estymowaną przez wartość średnią) i wariancję (jej estymatorem jest suma kwadratów odchyleń wartości sygnału od wartości oczekiwanej), a nawet widmo mocy. Można również rozważać szersze klasy modeli tego typu, jak np. model MA (ruchomej średniej, ang. moving average), gdzie uśredniamy [math]\epsilon_t[/math] zamiast [math]s(t)[/math], czy proces mieszany ARMA, opisany między innymi w klasycznych pozycjach „Analizie szeregów czasowych”, autorstwa Boxa i Jenkinsa oraz w „Metodach analizy szeregów czasowych” autorstwa Piersola i Bendata.

AR(1)

Najprostszym przykładem jest proces AR pierwszego rzędu (nazywany łańcuchem Markowa), w którym wartość w danej chwili zależy wyłącznie od wartości w chwili poprzedniej i szumu: [math] s[n] = a s[n-1] + \epsilon_n [/math]; podstawiając trzy kolejne wyrazy

[math]s[n] = \epsilon_n + a s[n-1] [/math]

[math]s[n-1] = \epsilon_{n-1} + a s[n-2] [/math]

[math]s[n-2] = \epsilon_{n-2} + a s[n-3][/math]

dostaniemy

[math]

s[n] =

[/math]

[math]

\epsilon_n + a s[n-1] =

[/math]

[math]

\epsilon_n + a \left( \epsilon_{n-1} + a s[n-2] \right) =

[/math]

[math]

\epsilon_n + a \left( \epsilon_{n-1} + a (\epsilon_{n-2} + a s[n-3]) \right) =

[/math]

[math]

\epsilon_n + a \epsilon_{n-1} + a^2 \epsilon_{n-2} + a^3 s[n-3]

[/math]

W ogólnym przypadku [math]N[/math] wyrazów będzie to suma

[math]

\displaystyle

s[n] = \sum_{i=0}^{N-1} a^i \epsilon_{n-i} + a^N s[n-N]

[/math]

Dla [math]N \rightarrow \infty[/math] zależność od pierwszego elementu [math]s[n-N][/math] zanika i dostajemy asymptotyczną reprezentację

[math] \displaystyle

s[n] = \epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2} +\ldots = \sum_{i=0}^{\infty} a^i \epsilon_{n-i}

[/math]

Jeśli wartość oczekiwana [math]\epsilon_i[/math] wynosi 0 ([math]E(\epsilon_i)=0[/math]) a wariancja

[math]\sigma^2(\epsilon_i)=\sigma_\epsilon^2[/math], to wariancja [math]s[n][/math] w punkcie [math]n[/math]

[math]\displaystyle

\begin{matrix}

\sigma^2_{s[n]} = E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1)^2\right) =\\

\\

= \sigma_\epsilon^2 \left(1+a^2+a^4+\ldots+a^{2n-2} \right) =

\left\{

\begin{matrix}

\sigma_\epsilon^2 \left(\frac{1-a^{2n}}{1-a^2} \right) & |a|\ne 1\\

n \sigma_\epsilon^2 & |a|=1

\end{matrix}

\right.

\end{matrix}[/math]

bo

[math] \sum_{k=1}^n b q^{k-1} = \left\{ \begin{matrix}b \frac{1 - q^n}{1 - q} \;\;\;\; \textrm{ dla }\;\;\;q\ne 1,\\ n b \;\;\;\;\;\;\;\;\; \textrm{ dla }\;\;\;\; q = 1. \end{matrix} \right. [/math]

Autokowariancja [math]E(s[n] s[n+\tau])[/math]

[math]

\displaystyle

\begin{matrix}

E\left( (\epsilon_n + a\epsilon_{n-1} + a^2\epsilon_{n-2}+\ldots+a^{n-1}\epsilon_1)

(\epsilon_{n+\tau} + a\epsilon_{n+\tau-1}

+\ldots+a^{n+\tau-1}\epsilon_1)\right) =\\

\\

= \sigma_\epsilon^2 \left(a^\tau+a^{\tau+2}+\ldots+a^{\tau+2(n-1)} \right) =

\left\{

\begin{matrix}

\sigma_\epsilon^2 a^\tau \left(\frac{1-a^{2n}}{1-a^2} \right) & |a|\ne 1\\

n \sigma_\epsilon^2 & |a|=1

\end{matrix}

\right.

\end{matrix}

[/math]

Dla [math]|a|\ne 1[/math] przy [math]n\rightarrow\infty[/math]

[math]\displaystyle

\sigma^2_{x[n]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon}{1-a^2} \;\;\; ; \;\;\;

\sigma_{x[n], x[n+\tau]} \stackrel{n\rightarrow\infty}{\longrightarrow} \frac{\sigma^2_\epsilon a^\tau}{1-a^2}

[/math]

Autokowariancja

[math]

\displaystyle

\rho(\tau) = \frac{ \sigma_{x[n], x[n+\tau]} }{ \sigma^2_{x[n]} } \stackrel{n\rightarrow\infty}{\longrightarrow} a^{|\tau|}

[/math]

Proces jest asymptotycznie stacjonarny do rzędu 2, czyli wariancja i średnia nie zależą od czasu.

Dla [math]a=1[/math] proces ten obrazuje tzw. błądzenie przypadkowe.

Na podstawie znajomości samego współczynnika [math]a[/math] modelu AR(1) policzyliśmy np. funkcję autokorelacji modelu, co daje już znajomość widma procesu (z przytoczonego poniżej twierdzenia Wienera-Chinczyna). Podobnie w procesach wyższych rzędów (1) znajomość współczynników [math]\{a_i\}_{i=1..M}[/math] daje nam dokładną wiedzę o własnościach generowanych przez nie procesów, bez znajomości sygnału [math]s[n][/math], którego wartości mogą różnić się w kolejnych realizacjach ze względu na element stochastyczny — szum [math]\epsilon[/math].

W praktyce analizy sygnału postępujemy odwrotnie — do konkretnej realizacji dopasowujemy model AR. Głównym problemem jest wybór rzędu modelu, estymacja współczynników [math]a_i[/math] najlepiej pasujących do danego sygnału posiada stabilne rozwiązania.

Twierdzenie Wienera-Chinczyna

Transformata Fouriera funkcji autokorelacji jest równa kwadratowi modułu transformaty Fouriera.

Dowód

Kładąc [math]f = g[/math] we wzorze na funkcję korelacji sygnałów f i g, dostajemy analogznie jak poprzednio

[math] \displaystyle \mathcal{F} \left( \int_{-\infty}^{\infty} f(t) f(t+\tau) dt \right) = [/math]

[math]

\displaystyle

\int_{-\infty}^{\infty} e^{-i\omega \tau} \left( \int_{-\infty}^{\infty} f(t) f(t+\tau) dt \right) d\tau =

[/math]

[math]

\displaystyle

\int_{-\infty}^{\infty} e^{-i\omega(t+\tau)} e^{i\omega t} \int_{-\infty}^{\infty} f(t) f(t+\tau) dt d\tau =

[/math]

[math]

\displaystyle

\int_{-\infty}^{\infty} e^{-i\omega(t+\tau)} f(t+\tau) d\tau \int_{-\infty}^{\infty} e^{i\omega t} f(t) dt =

[/math]

[math]

\displaystyle

\hat{f}(\omega) \overline{\hat{f}(\omega)} = |\hat{f}(\omega)|^2

[/math]

Estymacja współczynników AR i kryterium Akaike'go

Najtrudniejszym krokiem w estymacji współczynników modelu AR jest wybór rzędu [math]M[/math], czyli pamięci modelu. Pomagają w tym kryteria, których przykładem jest Akaike Information Criterion AIC:

- [math]\displaystyle \mathrm{AIC}(M)= \frac{2M}{N} + \ln(\sigma^2_{\epsilon}) [/math]

gdzie [math]N[/math] - liczba próbek sygnału. Kryterium to karze za zwiększanie liczby parametrów i nagradza za zmniejszanie niewytłumaczonej wariancji.

Parametryczna estymacja widma mocy sygnałów

Pokazaliśmy powyżej (na przykładzie błądzenia przypadkowego), że znając współczynniki (parametry) modelu AR możemy z nich wyliczyć funkcję autokorelacji odpowiadającego im procesu, bez znajomości konkretnej realizacji sygnału. Z kolei z funkcji autokorelacji możemy z pomocą powyższego twierdzenia obliczyć widmo. To widmo będzie wyliczone a nie estymowane, ale nie odnosi się bezpośrednio do sygnału, od którego zaczynaliśmy, tylko do procesu opisanego wyestymowanymi parametrami modelu AR.

Ogólnie w statystyce mówimy o:

- estymacji parametrycznej jako znajdowaniu nieznanych wartości parametrów rozkładu, oraz

- estymacji nieparametrycznej jako metodzie znajdowania postaci rozkładu populacji (analogicznie do testów nieparametrycznych).

Na przykład dla stu obserwacji, co do których zakładamy, że pochodzą z rozkładu normalnego, możemy znaleźć średnią i wariancję (parametry rozkładu) i na tej podstawie estymować prawdopodobieństwo w dowolnym przedziale. Jeśli nie chcemy zakładać postaci rozkładu, nieparametryczną estymatą n-tego percentyla będzie największy z pierwszych n wyników (dla próby o liczności 100).